一、数据质量概述

什么是数据质量

数据质量差的危害

数据质量维度(数据六大评价标准)

什么是数据质量测量

数据质量测量必须要有目的

数据质量测量必须可重复

数据质量测量必须可解释

什么是数据质量管理

二、数据问题根因分析

什么是根因分析

为什么要进行根因分析

产生数据问题的阶段

规划设计阶段

数据创建阶段

数据使用阶段

数据老化阶段

数据消亡阶段

产生问题的原因

业务原因

技术原因

管理原因

根因分析的方法

根因分析的工具

鱼骨图

5WHY图

故障树图

帕累托图

三、数据质量管理策略

四、数据质量管理工具

数据质量指标

数据质量维度

数据质量指标

权重和期望值

数据质量测量

数据质量剖析

数据质量问题分析与改进

一、数据质量概述

什么是数据质量

数据质量表示数据是否能满足业务需求或达到某种标准,能够满足需求的数据就是高质量数据,不能满足需求的数据就是低质量数据。

数据质量直接影响结果:

数据质量差的危害

数据质量差的危害很多,会导致数据统计不准确,进而导致决策不正确,损失金钱。还会增加各种各样的成本,沟通成本,数据处理成本等;客户看到数据变动较大或与实际出入过大会导致信誉度降低等一系列问题产生。

经济损失

成本增加

名誉受损

运营风险

数据质量维度(数据六大评价标准)

数据质量维度包含如下内容:准确性、一致性、有效性、及时性、完整性、唯一性;简称六性,他们各自的含义如下:

准确性:准确性是指数据记录的信息是否存在异常或错误。和一致性不一样,存在准确性问题的数据不仅仅只是规则上的不一致。更为常见的数据准确性错误就如乱码。其次,异常的大或者小的数据也是不符合条件的数据。

一致性:一致性是指数据是否遵循了统一的规范,数据集合是否保持了统一的格式;

**有效性:**对数据的值、格式要求符合数据定义或业务定义的要求,如电话、邮箱的格式

**及时性:**及时性是指数据从产生到可以查看的时间间隔,也叫数据的延时时长。及时性对于数据分析本身要求并不高,但如果数据分析周期加上数据建立的时间过长就可能导致分析得出的结论失去了借鉴的意义。

完整性:完整性是指数据信息是否存在缺失的状况,数据缺失的情况可能是整个数据记录确实,也可能是数据中某个字段信息的记录缺失,不完整的数据所能借鉴的价值就会大大降低,也是数据质量更为基础的一项评估工作。

**唯一性:**针对某个数据项或某组数据,没有重复的数据值,值必须是唯一的,如:ID类数据。

除了以上六性之外,有些资料还会有其他的性质,比如合理性、关联性等。

什么是数据质量测量

数据质量测量是指为了达到某种预期,按照一定的标准从数据质量维度进行衡量,以确定数据达到预期的程度。

数据质量测量必须要有目的

我们为什么要对数据进行质量测量,必须是有目的的,否则测量结果将毫无意义。

数据质量测量必须可重复

数据质量测量的结果必须是可以重复测量的,这代表着我们测量结果的准确性以及真实性。

数据质量测量必须可解释

我们通过数据质量测量的到的结果必须是可以解释通的,比如某个指标和实际差异过大,就要通过业务层次去解释为什么会差异过大。

什么是数据质量管理

数据质量管理就是我们对数据整个的生命周期都要对数据的质量进行管控,对数据从计划、 获取、存储、 共享、 维护、 应用到消亡生命周期的每个阶段可能引发的数据质量问题, 进行识别、 测量、 监控、 预警等一系列管理活动, 并通过改善和提高组织的管理水平使数据质量获得进一步提高。 数据质量管理的终极目标是通过可靠的数据提升数据在使用中的价值, 并最终为企业赢得经济效益。

二、数据问题根因分析

什么是根因分析

根因分析就是对可能导致某种问题的根本原因进行分析,要考虑多个层面的因素,比如导致数据质量差的原因可能有如下:人为因素、系统行为、流程因素、环境条件等。

找到导致问题的根本原因再找出适当的解决方案并制定预防措施。

问题:发生了哪些数据质量差的问题?

原因:为什么发生这些问题,导致这些问题的因素都有哪些?

措施:采取什么样的方法能够防止问题再次发生?

为什么要进行根因分析

“拨开迷雾见明月“分析任何问题都应该找到问题的本质。 进行数据质量问题的根因分析, 不仅在于解决业务部门和技术部门的矛盾, 更重要的是能够帮助企业利益干系人发现数据质量问题的症结所在, 从而找到适当的解决方案。

产生数据问题的阶段

数据是具有生命周期的,数据的“一生”要经历规划设计(定义) 、 数据创建、 数据使用、 数据老化、 数据消亡五个阶段, 每个阶段都有可能发生数据质量问题。

规划设计阶段

在数据设计阶段,数据的定义或设计不当会产生数据质量问题。

比如:数据字段存在二义性、手机号码长度限制等。

数据创建阶段

将不准确的数据录入到系统。

比如:数据拼写错误,数据录入错误,丢失数据记录,列表选择了不争取的选项。

数据使用阶段

在数据使用阶段, 要关注是否正确使用和解释了数据。

比如:“客户”数据在多个系统中共存,多个系统中重复录入,结构不一致。系统迁移过程中数据值的丢失、错位、不完整等。

数据老化阶段

数据不是静止的,是可能随着时间发生变化的。

比如:手机号的更换、客户联系人的变更。

数据消亡阶段

数据消亡阶段, 对使用完的数据进行归档及销毁操作。

产生问题的原因

业务原因

数据需求模糊、对数据的定义、业务规则描述不清、频繁的需求变更。

数据录入不规范,大小写、全半角、特殊字符。

技术原因

数据表设计过程中约束条件、校验规则不合理等。

数据迁移过程中数据的采集、清洗、转换不合理等。

管理原因

缺乏数据管理策略,建设初期没有对数据质量进行管控、数据变更流程不完善。

缺乏统一的数据标准,对于同一数据理解不一致, 业务之间的协作和沟通就如同“鸡同鸭讲”

根因分析的方法

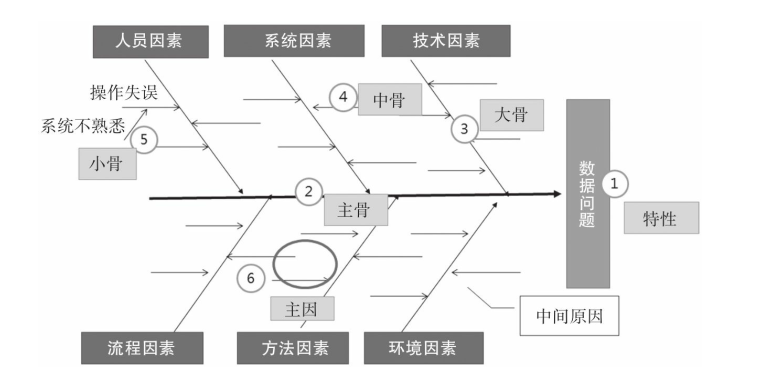

如下图:

根因分析的工具

鱼骨图

鱼骨图是由日本管理大师石川馨先生提出的一种把握结果和原因的方便而有效的方法, 故名“石川图”。 它是一种透过现象看本质的分析方法, 非常适用于数据质量问题的根因分析。鱼骨图是因果分析中常用的工具。

首先, 需要从多个维度对引发问题的直接原因进行归集;

其次, 依次列出直接原因所导致的问题“事实”;

然后, 分析每一个“事实”发生的原因;

最后, 找到导致问题发生的根本原因。 鱼骨图有助于探索阻碍结果的因素, 适用于数据质量问题的分析。

5WHY图

5Why分析法的精髓就是多问几个为什么, 鼓励解决问题的人努力避开主观假设和逻辑陷阱, 从结果着手, 沿着因果关系链条顺藤摸瓜, 穿越不同的抽象层面, 直至找出原有问题的根本原因。

故障树图

故障树图是一种逻辑因果关系图, 是一种图形演绎法, 是故障事件在一定条件下的逻辑推理方法, 可针对某一故障事件进行层层追踪分析。 故障树图的特点是直观明了, 思路清晰, 逻辑性强, 既可以进行定性分析, 也可以进行定量分析。 它体现了以系统工程方法研究安全问题的系统性、准确性和预测性。

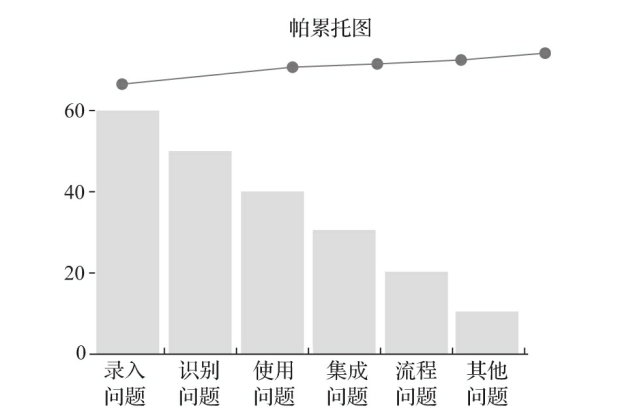

帕累托图

帕累托图是条形图和折线图的组合, 条形图的长度代表问题的频率, 折线表示累积频率, 横坐标表示影响质量的各项因素, 按影响程度的大小(出现频数) 从左到右排列 。 通过对排列图的观察分析可以抓住影响质量的主要因素, 进而确定问题的优先级。

帕累托图是基于80/20法则的分析, 即认为发生的全部问题中有80%是由20%的问题原因引起的。 这意味着, 如果有针对主要问题的解决方案, 则可以解决大部分的数据质量问题。

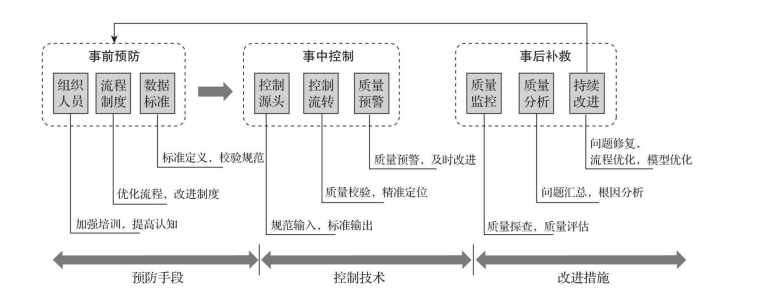

三、数据质量管理策略

数据质量管理应秉持预防为主的理念, 坚持将“以预控为核心, 以满足业务需求为目标”作为工作的根本出发点和落脚点, 加强数据质量管理的事前预防、 事中控制、 事后补救的各种措施, 以实现企业数据质量的持续提升。

事前预防策略:

加强培训

制定数据标准

制定规范

制定数据管理流程

事中控制策略:

维护好数据字典

自动化数据录入

自动化数据校验

人工干预审核

使用预警机制

数据质量报告

使用先进的技术

事后补救策略:

定期质量监控

清理重复数据

清理派生数据

缺失值处理

异常值处理

持续改进优化

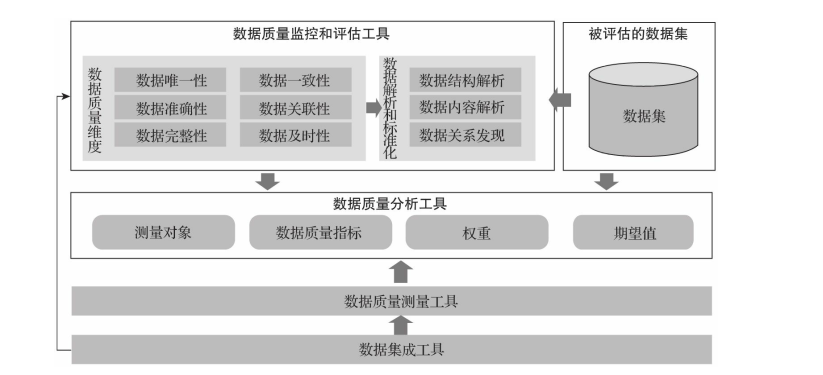

四、数据质量管理工具

数据质量管理工具用于为企业特定的数据集定义数据质量规则, 进行数据质量评估, 开展数据质量稽核, 并促进企业数据质量及相关业务流程的优化和改进。

数据质量管理是用于识别、 理解和纠正数据缺陷的过程, 通过数据缺陷的发现和纠正提升企业数据质量, 以支持企业的业务协同和决策支持。 在实践中, 数据质量管理工具具有一系列关键功能, 如数据质量分析、 数据解析、 数据标准化、 数据清洗、 数据匹配、 数据集成和数据质量监控等。

数据解析和标准化工具: 将数据进行分解和剖析, 并将其统一化、 标准化。

数据清理工具: 删除不正确或重复的数据条目, 修正数据项的值域, 以满足某些业务规则或标准。

数据分析工具: 收集有关数据质量的统计信息, 然后将其用于数据质量测量和评估。

数据质量监控工具: 对数据质量状态进行监控, 及时发现数据质量问题。

数据集成工具: 引入外部数据并将其集成到现有数据中。

数据质量指标

定义数据质量指标是数据质量测量和管理的第一步, 主要涉及数据质量维度、 数据质量指标、 权重和期望值等。 数据质量指标是由业务人员根据各测量类别对不同业务实体提出的数据质量衡量标准, 它是各数据质量测量类别在不同业务实体上的具体体现。

数据质量维度

企业的数据质量维度一般包括数据唯一性、 一致性、 准确性、 关联性、 完整性、 及时性等。 数据质量维度反映了数据质量不同的规格标准, 也体现了高层次的指标度量的特点。

数据质量指标

针对不同的数据质量检核对象, 依据数据质量维度, 定义数据质量指标。每个数据质量指标都是从业务实体的角度对质量问题进行简单描述, 都包含一个或多个信息项, 这些信息项就是每一个业务实体具体要检核的对象。 我们可以在每一个数据质量指标的基础上根据不同的信息项确定具体的检核方法。

权重和期望值

依据实际业务所需为数据质量指标定义度量的标准, 一个数据质量指标可以设置多个度量标准, 为每个度量指标设置可接受的阈值、 权重等。 例如:对“有效客户”的度量, 就需要设置多个维度的度量指标, 如最后一次登录时间、 访问频次、 有效交易次数、 最后一次交易时间等。 度量指标得分低于可接受水平的数据不符合业务用户的期望, 必须加以改进以避免对业务和分析产生负面影响。

数据质量测量

数据质量测量是数据质量管理平台的核心功能, 支持基于给定数据质量维度、 数据质量规则和指标对目标数据集实施定期或持续的测量。

测量方法

任务调度

持续测量

定期测量

数据质量剖析

用各种统计和分析算法以及业务规则来探究数据集的内容及其数据元素的特征。 数据质量管理工具支持以下三种数据质量剖析类型。

数据结构解析: 用于了解数据是否一致, 格式化描述是否正确。 通过检查数据中的统计信息, 例如最小值和最大值、 中位数、 均值或标准差, 了解数据的有效性。

数据内容解析: 通过检查数据库中的单个数据记录, 发现空值或错误值,包括格式错误。

数据关系发现: 用于分析和理解数据集、 数据记录、 数据库字段或数据实体之间的关联关系。 通过此分析, 可以发现并消除数据集中可能出现的数据重复、 数据参照不完整等问题

数据质量问题分析与改进

通过对不同业务需求和数据质量问题的收集、 分类、 抽象和概括, 采用定量和定性的数据质量分析方法, 对数据质量问题进行评估, 确定哪些数据缺陷对业务流程有重大影响, 为下一步制定数据问题的解决方案奠定基础。

数据质量分析报告: 数据质量管理工具提供了一个集中展示数据质量状况的窗口, 相关人员可以对数据质量问题进行查询、 统计、 分析, 找到引起数据质量问题的根因并付诸行动, 从源头上解决数据质量问题, 实现数据质量管理的闭环。

数据质量问题分析: 数据质量管理工具提供对问题数据记录的检索和查询功能, 重点关注对问题数据记录的监控、 对问题数据数量变化的趋势分析、 对不同测量类别的数据分布的分析等。

数据质量仪表板: 以仪表板的形式展示对数据质量问题的统计分析, 展示各评估维度的问题数据的数据量及变化趋势, 以更直观的方式查看数据质量问题的变化以及对质量问题的治理结果。